Александр Молдовян - Информатика: введение в информационную безопасность

- Название:Информатика: введение в информационную безопасность

- Автор:

- Жанр:

- Издательство:Array Литагент «Юридический центр»

- Год:2004

- Город:Санкт-Петербург

- ISBN:5-94201-399-3

- Рейтинг:

- Избранное:Добавить в избранное

-

Отзывы:

-

Ваша оценка:

Александр Молдовян - Информатика: введение в информационную безопасность краткое содержание

Издание адресовано студентам высших учебных заведений, обучающимся по направлениям подготовки бакалавров 553000 «Системный анализ и управление» и 553500 «Защита окружающей среды». Авторы выражают надежду, что представленный материал окажется полезным и студентам других, в частности гуманитарных и социально-экономических, направлений и специальностей, а также преподавателям дисциплины «Информатика».

Информатика: введение в информационную безопасность - читать онлайн бесплатно ознакомительный отрывок

Интервал:

Закладка:

«Информационные модели» социальных организмов кроме сведений, получаемых самостоятельно, включают сведения, поступающие от других членов коллектива. Составляющие «информационных моделей» социальных организмов, образуемые за счет сведений, получаемых от других организмов, составляют отражение движения объектов материального мира в коллективе живых организмов, т. е. распределенную «информационную модель».

Особенность человека как носителя сведений состоит в возможности накопления сведений в его «информационной модели», определяемой характеристиками его памяти. Человек обладает уникальной способностью формировать понятия, а также получать новые сведения и знания посредством оперирования с возможными отношениями между понятиями и оценки соответствия вырабатываемых сведений и знаний уже имеющимся в его «информационной модели». Эта способность называется мышлением.

Информация (от латинского informatio – разъяснение, изложение). Первоначально – сведения, передаваемые людьми устным, письменным или другим способом (с помощью условных сигналов, технических средств и т. д.). С середины ХХ века – общенаучное понятие, включающее обмен сведениями между людьми, человеком и автоматом, автоматом и автоматом, обмен сигналами в животном и растительном мире, передача сигналов от клетки к клетке, от организма к организму [27] Большой советский энциклопедический словарь. – М., 1990. С. 504.

.

В справочной философской литературе последнего времени понятие «информация» раскрывается как «одно из наиболее общих понятий науки, обозначающее некоторые сведения, совокупность каких-либо данных, знаний и т. п.» [28] Всемирная энциклопедия философии. – М., 2001. С. 428.

. При этом отмечается, что «само понятие “информация” обычно предполагает наличие, по крайней мере, трех объектов – источника информации, потребителя информации и передающей среды. Информация не может быть передана, принята или хранима в чистом виде. Носителем информации является сообщение». Н. Н. Моисеев, например, выделяет в информации сведения и сигнал, с которым связано получение сведений [29] Моисеев Н. Н. Универсум. Информация. Общество. – М., 2001. С. 51.

. И хотя, как отмечает А. А. Стрельцов, понятие «сигнал» несколько беднее, чем понятие «сообщение», важно отметить, что и в данном случае речь идет о необходимости разделения сведений и способа их передачи.

В своем общении мы чаще всего воспринимаем информацию как общелексическое понятие, хотя она существует и как естественно-научная категория, и как философская, мировоззренческая. На общелексическом, бытовом уровне понятие «информация» обычно толкуется как «сообщение, осведомляющее о положении дел, о состоянии чего-нибудь» [30] Ожегов С. И., Шведова Н. Ю. Толковый словарь русского языка. – М., 1992. С. 255.

. Заметим, что и в нормативных правовых актах чаще всего данное понятие употребляется именно в этом смысле. Попытки изучения информации как более широкой категории, чем сообщение, передаваемое от человека человеку, начались примерно в 20-х годах XX века, причем вначале в рамках гуманитарных наук, исследовавших массовые и индивидуальные коммуникации (системы связей и общения).

Теория и практика журналистики стала первой сферой, где начали выявляться характеристики информации, оказавшие впоследствии воздействие не только на теорию массовых коммуникаций, но и на теоретические представления об информации, сложившиеся впоследствии в кибернетике. Предметом теории журналистики является сфера массово-информационной деятельности. Она изучает особенности журналистских текстов, закономерности массово-информационной деятельности в системах отношений «журналист – аудитория» и связи «информация – общественное мнение» [31] Прохоров Е. П . Введение в теорию журналистики: Учеб. пособие. – М., 1995. С. 24.

. Однако журналистика и нормативные правовые акты, регулирующие систему массовой информации, так и не отошли от общеупотребительной трактовки данного понятия. В частности, Закон РСФСР «О средствах массовой информации», принятый в 1991 году, определяет массовую информацию как «предназначенные для неограниченного круга лиц печатные, аудиовизуальные и иные сообщения и материалы» [32] Российская газета. 1991. 9 авг. (ВВС РФ. 1992. № 7. Ст. 300).

. Такие подходы делают тождественными понятия «информация» и «сообщение», хотя это верно только по отношению к информации, исходящей от человека и обращаемой им в сигналы, символы или звуки. Однако информация об окружающей действительности, которую человек получает через свои органы чувств, далеко не во всех случаях исходит от другого человека (например, температура окружающей среды, рельеф местности и т. п.).

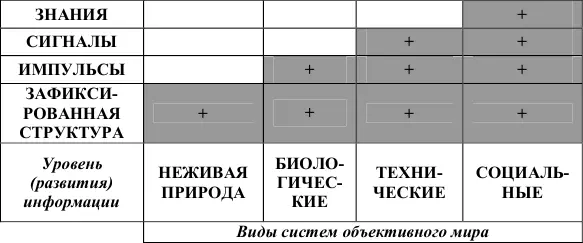

В упомянутой выше работе, замечая, что определение чрезвычайно широких понятий сводится к указанию их наиболее характерных признаков, В. А. Герасименко иллюстрирует предпринятую им попытку структуризации понятия «информация» (рис. 1).

ИНФОРМАЦИЯ – основополагающее, вместе с тем чрезвычайно емкое, в высокой степени неопределенное (формально) понятие (в силу его необычности – многообразия форм и проявлений).

Рис. 1. Формы представления информации

Наиболее плодотворное развитие проблематика проникновения в сущность понятия «информация» получила в рамках теории информации и кибернетики. Теория информации начинается с работ Клода Шеннона, опубликованных в конце 40-х годов XX века. В классической теории информации преимущественно уделялось внимание тем аспектам информации, которые могут быть названы техническими. Из полученных в рамках этой теории результатов наибольшее значение имели те, которые относятся к теории и практике кодирования информации, а также к анализу и синтезу систем передачи информации по техническим каналам связи.

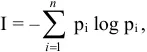

К. Шеннон предложил единицу измерения информации – бит , приписав каждому сигналу априорную вероятность его появления. Количество информации описывается формулой вида

где p i– вероятность появления i-го сигнала;

n – количество возможных сигналов [33] Знак минус в формуле поставлен для того, чтобы значение количества информации оказалось положительным, поскольку вероятность – величина всегда меньшая или равная единице.

.

Формула показывает зависимость количества информации от числа событий и вероятности совершения этих событий. Чем меньше вероятность появления того или иного сигнала (наступления события), тем больше информации он несет для потребителя. (В обыденном понимании – чем неожиданнее новость, тем больше ее информативность.) Информация равна нулю, когда возможно только одно событие. С ростом числа событий она увеличивается и достигает максимального значения, когда события равновероятны. Если событий всего два и они равновероятны, то выше представленная формула примет вид

Читать дальшеИнтервал:

Закладка: