Эдуардо Арройо - Том 42. Путешествие от частицы до Вселенной. Математика газовой динамики

- Название:Том 42. Путешествие от частицы до Вселенной. Математика газовой динамики

- Автор:

- Жанр:

- Издательство:«Де Агостини»

- Год:2014

- ISBN:978-5-9774-0772-4

- Рейтинг:

- Избранное:Добавить в избранное

-

Отзывы:

-

Ваша оценка:

Эдуардо Арройо - Том 42. Путешествие от частицы до Вселенной. Математика газовой динамики краткое содержание

Возможно ли, заглянув в пустой сосуд, увидеть карту нашей Вселенной? Ответ: да! Ведь содержимое пустого (на первый взгляд) сосуда — это бурлящий мир, полный молекул, которые мчатся с головокружительными скоростями. А поведение молекул газа иллюстрирует многочисленные математические теории, принципиально важные для понимания мироустройства. Именно исследования свойств газа позволили ученым ближе рассмотреть такие сложные понятия, как случайность, энтропия, теория информации и так далее. Попробуем и мы взглянуть на Вселенную через горлышко пустого сосуда!

Том 42. Путешествие от частицы до Вселенной. Математика газовой динамики - читать онлайн бесплатно полную версию (весь текст целиком)

Интервал:

Закладка:

Можем пойти еще дальше и задать вопрос, какова минимально возможная энтропия для любой системы и какому количеству микросостояний она соответствует.

Вспомним, что энтропия равна:

S = k · log W ,

где функция log — это логарифм, функция, обратная экспоненте. Предположим, что у нас только одно микросостояние: в этом случае логарифм единицы равен нулю, поскольку любое число, возведенное в нулевую степень, равно единице. Итак, энтропия одного микросостояния равна нулю. С точки зрения непредсказуемости это справедливо: нет более предсказуемой системы, чем та, у которой только одно состояние. Ее непредсказуемость точно равна нулю.

Есть и другой способ понимания энтропии, который может быть адаптирован для применения за пределами физики — в рамках теории информации. Речь идет о понимании энтропии как недостающей информации о системе, то есть о степени нашей неосведомленности.

Как было видно в предыдущей главе, обычно мы знаем давление, температуру и объем газа, но при этом не знаем всего остального, то есть мы обладаем смехотворным количеством информации, необходимой для описания состояния системы.

Пусть даже эта информация — единственно значимая для прогнозирования, но она остается крайне малой по сравнению со всей информацией о рассматриваемом газе. Главную роль в способе описания энтропии снова играет число доступных микросостояний. Если в системе миллион состояний и мы не знаем, в каком из них она находится, степень нашей неосведомленности намного больше, чем если бы в ней было только десять состояний. Итак, мы знаем о системе с высокой энтропией намного меньше, чем о системе с низкой энтропией.

Какой же смысл в том, чтобы принимать энтропию за информацию? Информации нужен наблюдающий субъект — это не что-то, что можно потрогать. Когда мы говорим «энтропия системы — это степень нашей неосведомленности о ней», кажется, будто мы утверждаем, что энтропия не имеет реального существования во Вселенной, это просто человеческое понятие, которое измеряет то, что мы знаем, и не более.

Действительно, есть системы, для которых понятие энтропии не имеет смысла. В системе, состоящей из предмета, прикрепленного к пружине, и самой пружины, нет никакой энтропии: само это понятие неприменимо к ситуации. Энтропия — макроскопическая величина и сама по себе применима только для скоплений частиц. Однако в фундаментальных законах Вселенной о ней нет никакого упоминания: речь идет о статистическом понятии, которое помогает нам осмыслить некоторые характеристики сложных систем.

Именно понимание энтропии как меры информации привело американского математика Клода Шеннона(1916–2001) к использованию ее в качестве ключевого элемента в своей теории информации.

Предположим, что мы опаздываем на ужин с нашей второй половинкой и хотим послать ей сообщение: «Сегодня я опоздаю на ужин». Для этого наш мобильный телефон должен обработать информацию, содержащуюся в нашем сообщении, перевести ее в электрические импульсы и послать ее с помощью электромагнитных волн. Телефонной компании хотелось бы использовать минимальное количество энергии для передачи нашего сообщения, поскольку энергия стоит денег. Так что ей нужно знать минимальное количество информации, которое должно быть зашифровано.

Первая мысль, которая приходит в голову, заключается в том, что компания должна зашифровать столько информации, сколько букв в сообщении. Например, «Сегодня я опоздаю на ужин» содержит 21 единицу информации или 25, если считать пробелы. Но мы ошибаемся, потому что в одной букве содержится больше, чем одна единица информации. Итак, прежде всего мы должны подумать о том, что такое информация и как ее можно измерить.

Понятие информации связано с понятием сообщения: предположим, что каждый раз, когда мы посылаем сообщение, мы передаем информацию. Если мы определим самое простое сообщение, которое можем послать, оно и будет минимальной единицей информации.

В нашу информационную эпоху все знают о том, что минимальной единицей информации является бит. Бит — это единица или ноль, аналог ответа на вопрос: «да» или «нет». Не существует меньшей единицы, ведь наименьшее, что мы можем передать, это присутствие или отсутствие чего-либо. Чтобы узнать содержание сообщения, мы должны перевести его в биты.

Посмотрим, как можно зашифровать фразу «Сегодня я опоздаю на ужин» в битах. При этом мы можем шифровать только два типа данных: ноль или один. Однако в двух битах мы можем зашифровать четыре: 00, 01,10, 11. В трех битах у нас уже восемь возможностей: 000, 001, 010, 011, 100, 101, 110, 111. А для n бит у нас есть 2 n возможностей, то есть два, умноженное на себя n раз. Каково минимальное число битов, нужное нам, чтобы зашифровать буквы алфавита? Поскольку в латинском алфавите 26 букв, нам потребуется по крайней мере 26 возможностей. Наиболее близкая степень двух — 32, или 23, так что минимальное необходимое число битов для того, чтобы зашифровать букву, равно пяти.

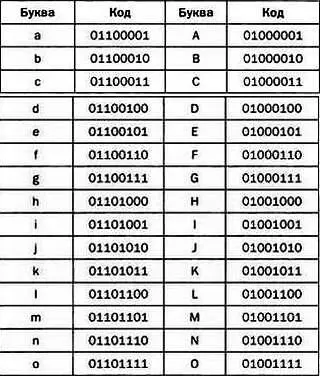

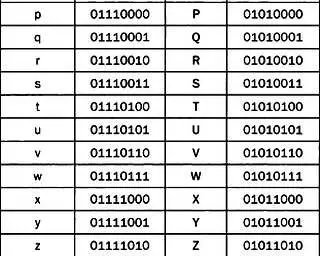

На практике для шифрования буквы используется более пяти битов, поскольку у нас есть заглавные буквы и различные символы, которые также нужно связать с последовательностью битов. Обычно используют восемь битов, из которых составлен так называемый код ASCII, который позволяет представить каждую букву в виде последовательности единиц и нулей. Например, буква асоответствует последовательности 01100001.

Коды ASCIIдля заглавных и строчных букв. Существует 8-битная кодировка кириллического алфавита, совместимая с ASCII, — КОИ-8.

Поскольку каждой букве соответствуют восемь битов, а наше сообщение содержит двадцать пять букв, мы можем сосчитать, сколько информации в нем содержится:

25·8 = 200 битов.

В целом мы можем представить любую цепочку символов в качестве цепочки битов, информация которой обычно равна ее длине. Но это не всегда так. Например, возьмем цепочку:

1111111111111111111111111111111111111111111111.

Это сообщение содержит 46 битов, но они несут меньше информации, чем могли бы, поскольку здесь повторяется одна и та же цифра. Действительно, если бы мы хотели продлить цепочку, то легко могли бы догадаться, что следующий символ — тоже единица. Итак, предсказуемость цепочки делает информацию, которую она содержит, меньшей, чем ее длина в битах. Именно здесь вступает понятие энтропии: предсказуемая цепочка битов характеризуется меньшим количеством энтропии и, следовательно, меньшим количеством непредсказуемой информации. Поэтому энтропия — хорошая мера информации, содержащейся в цепочке битов.

Читать дальшеИнтервал:

Закладка: