Николай Чурсин - Популярная информатика

- Название:Популярная информатика

- Автор:

- Жанр:

- Издательство:Техника

- Год:1980

- Город:Киев

- ISBN:нет данных

- Рейтинг:

- Избранное:Добавить в избранное

-

Отзывы:

-

Ваша оценка:

Николай Чурсин - Популярная информатика краткое содержание

Популярная информатика - читать онлайн бесплатно полную версию (весь текст целиком)

Интервал:

Закладка:

Выход из положения был найден Р. Хартли, который предложил информацию I , приходящуюся на одно сообщение, определять логарифмом общего числа возможных сообщений N :

I ( N ) = log N

(1)

Если же все множество возможных сообщений состоит из одного ( N = m = 1), то I ( N ) = log 1 = 0, что соответствует отсутствию информации в этом случае. При наличии независимых источников информации с N 1и N 2числом возможных сообщений

I ( N ) = log N = log N 1 N 2= log N 1+ log N 2,

т. е. количество информации, приходящееся на одно сообщение, равно сумме количеств информации, которые были бы получены от двух независимых источников, взятых порознь. Формула, предложенная Хартли, удовлетворяет предъявленным требованиям. Поэтому ее можно использовать для измерения количества информации.

Если возможность появления любого символа алфавита равновероятна (а мы до сих пор предполагали, что это именно так), то эта вероятность р = 1/ m . Полагая, что N = m ,

I = log N = log m = log (1/ p ) = — log p ,

(2)

т. е. количество информации на каждый равновероятный сигнал равно минус логарифму вероятности отдельного сигнала.

Полученная формула позволяет для некоторых случаев определить количество информации. Однако для практических целей необходимо задаться единицей его измерения. Для этого предположим, что информация — это устраненная неопределенность. Тогда в простейшем случае неопределенности выбор будет производиться между двумя взаимоисключающими друг друга равновероятными сообщениями, например между двумя качественными признаками: положительным и отрицательным импульсами, импульсом и паузой и т. п. Количество информации, переданное в этом простейшем случае, наиболее удобно принять за единицу количества информации. Именно такое количество информации может быть получено, если применить формулу (2) и взять логарифм по основанию 2. Тогда

I = — log 2 p = — log 21/2 = log 22 = 1.

Полученная единица количества информации, представляющая собой выбор из двух равновероятных событий, получила название двоичной единицы, или бита. Название bit образовано из двух начальных и последней букв английского выражения binary unit , что значит двоичная единица. Бит является не только единицей количества информации, но и единицей измерения степени неопределенности. При этом имеется в виду неопределенность, которая содержится в одном опыте, имеющем два равновероятных исхода.

На количество информации, получаемой из сообщения, влияет фактор неожиданности его для получателя, который зависит от вероятности получения того или иного сообщения. Чем меньше эта вероятность, тем сообщение более неожиданно и, следовательно, более информативно. Сообщение, вероятность которого высока и, соответственно, низка степень неожиданности, несет немного информации.

Р. Хартли понимал, что сообщения имеют различную вероятность и, следовательно, неожиданность их появления для получателя неодинакова. Но, определяя количество информации, он пытался полностью исключить фактор «неожиданности». Поэтому формула Хартли позволяет определить количество информации в сообщении только для случая, когда появление символов равновероятно и они статистически независимы. На практике эти условия выполняются редко. При определении количества информации необходимо учитывать не только количество разнообразных сообщений, которые можно получить от источника, но и вероятность их получения.

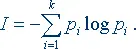

Наиболее широкое распространение при определении среднего количества информации, которое содержится в сообщениях от источников самой разной природы, получил подход. К Шеннона. Рассмотрим следующую ситуацию.

Источник передает элементарные сигналы k различных типов. Проследим за достаточно длинным отрезком сообщения. Пусть в нем имеется N 1сигналов первого типа, N 2сигналов второго типа…, N k сигналов k -го типа, причем N 1+ N 2+… + N k = N — общее число сигналов в наблюдаемом отрезке, f 1, f 2…, f k — частоты соответствующих сигналов. При возрастании длины отрезка сообщения каждая из частот стремится к фиксированному пределу, т. е.

lim f i = p i , ( i = 1, 2…, k ),

где р i можно считать вероятностью сигнала. Предположим, получен сигнал i -го типа с вероятностью р i , содержащий — log p i единиц информации. В рассматриваемом отрезке i -й сигнал встретится примерно Np i раз (будем считать, что N достаточно велико), и общая информация, доставленная сигналами этого типа, будет равна произведению Np i log р i . То же относится к сигналам любого другого типа, поэтому полное количество информации, доставленное отрезком из N сигналов, будет примерно равно

Чтобы определить среднее количество информации, приходящееся на один сигнал, т. е. удельную информативность источника, нужно это число разделить на N . При неограниченном росте приблизительное равенство перейдет в точное. В результате будет получено асимптотическое соотношение — формула Шеннона

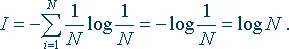

В последнее время она стала не менее распространенной, чем знаменитая формула Эйнштейна Е = mc 2. Оказалось, что формула, предложенная Хартли, представляет собой частный случай более общей формулы Шеннона. Если в формуле Шеннона принять, что

р 1= p 2=… = р i =… = p N = 1/ N , то

Знак минус в формуле Шеннона не означает, что количество информации в сообщении — отрицательная величина. Объясняется это тем, что вероятность р , согласно определению, меньше единицы, но больше нуля. Так как логарифм числа, меньшего единицы, т. е. log p i — величина отрицательная, то произведение вероятности на логарифм числа будет положительным.

Кроме этой формулы, Шенноном была предложена абстрактная схема связи, состоящая из пяти элементов (источника информации, передатчика, линии связи, приемника и адресата), и сформулированы теоремы о пропускной способности, помехоустойчивости, кодировании и т. д.

В результате развития теории информации и ее приложений идеи Шеннона быстро распространяли свое влияние на самые различные области знаний. Было замечено, что формула Шеннона очень похожа на используемую в физике формулу энтропии, выведенную Больцманом. Энтропия обозначает степень неупорядоченности статистических форм движения молекул. Энтропия максимальна при равновероятном распределении параметров движения молекул (направлении, скорости и пространственном положении). Значение энтропии уменьшается, если движение молекул упорядочить. По мере увеличения упорядоченности движения энтропия стремится к нулю (например, когда возможно только одно значение и направление скорости). При составлении какого-либо сообщения (текста) с помощью энтропии можно характеризовать степень неупорядоченности движения (чередования) символов. Текст с максимальной энтропией — это текст с равновероятным распределением всех букв алфавита, т. е. с бессмысленным чередованием букв, например: ЙХЗЦЗЦЩУЩУШК ШГЕНЕЭФЖЫЫДВЛВЛОАРАПАЯЕЯЮЧБ СБСЬМ. Если при составлении текста учтена реальная вероятность букв, то в получаемых таким образом «фразах» будет наблюдаться определенная упорядоченность движения букв, регламентируемая частотой их появления: ЕЫТ ЦИЯЬА ОКРВ ОДНТ ЬЧЕ МЛОЦК ЗЬЯ ЕНВ ТША.

Читать дальшеИнтервал:

Закладка: