Дэвид Шпигельхалтер - Искусство статистики. Как находить ответы в данных

- Название:Искусство статистики. Как находить ответы в данных

- Автор:

- Жанр:

- Издательство:Манн, Иванов и Фербер

- Год:2021

- Город:Москва

- ISBN:9785001692508

- Рейтинг:

- Избранное:Добавить в избранное

-

Отзывы:

-

Ваша оценка:

Дэвид Шпигельхалтер - Искусство статистики. Как находить ответы в данных краткое содержание

Эта книга предназначена как для студентов, которые хотят ознакомиться со статистикой, не углубляясь в технические детали, так и для широкого круга читателей, интересующихся статистикой, с которой они сталкиваются на работе и в повседневной жизни. Но даже опытные аналитики найдут в книге интересные примеры и новые знания для своей практики. На русском языке публикуется впервые.

Искусство статистики. Как находить ответы в данных - читать онлайн бесплатно ознакомительный отрывок

Интервал:

Закладка:

Оценивание эффективности алгоритма

Если алгоритмы будут сравниваться по точности, нужно решить, что означает «точный». В конкурсной задаче о «Титанике» на платформе Kaggle это просто процентная доля пассажиров в тестовом наборе, которых алгоритм правильно классифицировал. Поэтому, после того как участники конкурса сконструируют алгоритмы, они дают свой прогноз на переменную отклика для тестового набора, а Kaggle измеряет точность прогнозов. Мы представим результаты сразу для всего тестового набора (подчеркнем, что это не то же самое, что тестовый набор Kaggle [128]).

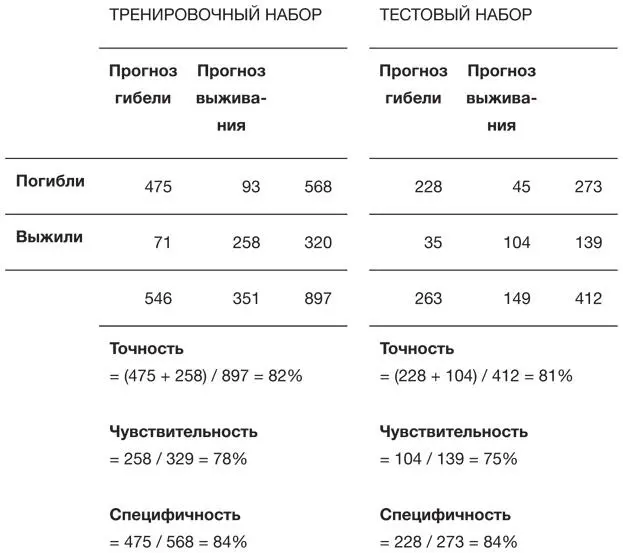

Если применить дерево классификации, приведенное на рис. 6.3, к тренировочным данным, для которых оно разработано, то оно даст точность 82 %. Если этот алгоритм использовать на тестовом наборе, точность слегка упадет – до 81 %. В табл. 6.1 приведено число разных типов ошибок, допущенных алгоритмом; эта таблица называется матрицей ошибок. Когда мы пытаемся определить выживших, процент верно предсказанных из числа реально выживших именуется чувствительностьюалгоритма, а процент верно предсказанных из числа реально погибших – специфичностью. Эти термины взяты из медицинских диагностических исследований [129].

Таблица 6.1

Матрица ошибок дерева классификации для тренировочных и тестовых данных, где отображается точность (% правильно классифицированных), чувствительность (% правильно классифицированных выживших) и специфичность (% правильно классифицированных погибших)

Хотя общую точность выразить достаточно просто, это очень грубая мера эффективности, не учитывающая, с какой надежностью делается прогноз. Если мы посмотрим на кончики ветвей дерева классификации, то увидим, что разделение тренировочных данных не идеально: на всех ветвях кто-то выжил, а кто-то – нет. При грубом правиле распределения мы просто выбираем результат большинства, но можем поступить и иначе, присвоив каждому новому случаю вероятность выживания, соответствующую доле выживших в тренировочном наборе. Например, человеку с формой обращения «мистер» мы могли бы дать вероятность выживания 16 %, а не просто однозначно предсказать, что он погибнет.

Алгоритмы, которые дают не простую классификацию, а вероятность (или какое-то другое число), часто сравниваются с помощью ROC-кривых [130], которые изначально были разработаны во время Второй мировой войны для анализа радиолокационных сигналов. Ключевая идея – возможность варьировать пороговое значение, при котором дается прогноз выживания. В табл. 6.1 показан эффект использования порогового значения 50 % для прогноза выживания, при этом значения специфичности и чувствительности в тренировочном наборе соответственно равны 0,84 и 0,78. Однако мы могли бы потребовать более высокую вероятность для предсказания, что кто-то выживет, например 70 %; в этом случае специфичность и чувствительность составили бы 0,98 и 0,50 соответственно. При таком более строгом пороговом значении мы правильно определим только половину реально выживших, но зато сделаем о них очень мало ложных утверждений. Если взять все пороговые значения для предсказания выживания, то все возможные значения для специфичности и чувствительности образуют кривую. Обратите внимание, что при изображении ROC-кривой значения специфичности традиционно идут по горизонтальной оси, уменьшаясь от 1 до 0.

На рис. 6.4 изображены ROC-кривые для тренировочного и тестового набора. Если алгоритм распределяет числа случайным образом (то есть абсолютно бесполезен), то его ROC-кривая будет диагональной линией. У самых лучших алгоритмов ROC-кривые подходят близко к левому верхнему углу. Стандартный способ сравнения разных ROC-кривых – измерить площадь под ними. Для бесполезного алгоритма она равна 0,5, а для идеального – 1. Для нашего тестового набора для данных о «Титанике» площадь под кривой составляет 0,82. Оказывается, для этой площади есть изящная интерпретация: если мы выбираем истинно выжившего и истинно погибшего случайным образом, то с вероятностью 82 % алгоритм дает истинно выжившему б о льшую вероятность выживания, чем истинно погибшему. Области свыше 0,80 представляют весьма хорошую эффективность разделения. Площадь под ROC-кривой – это способ измерить, насколько точно алгоритм отделяет выживших от погибших, но она не отражает сами вероятности. Категория специалистов, которые лучше всего знакомы с вероятностными прогнозами, – это синоптики.

Рис. 6.4

ROC-кривые для дерева классификации, приведенного на рис. 6.3, примененные к тренировочному (пунктирная линия) и тестовому (сплошная линия) набору данных. «Чувствительность» – доля правильно предсказанных выживших. «Специфичность» – доля правильно предсказанных погибших. Площади областей под кривыми равны 0,84 и 0,82 для тренировочного и тестового набора соответственно

Как узнать, насколько точны прогнозы «вероятности осадков»?

Предположим, мы хотим предсказать, будет ли завтра дождь в конкретном месте в конкретное время. Простейшие алгоритмы могут просто давать ответ в виде «да/нет», и он может оказаться правильным или неправильным. Более сложные модели могут выдавать вероятность дождя, что позволяет принимать более точные решения, ведь ваши действия при вероятности дождя в 50 % могут сильно отличаться от действий, если алгоритм выдаст 5-процентную вероятность.

На практике прогнозы погоды основываются на крайне сложных компьютерных моделях, которые включают подробные математические формулы, отображающие развитие погоды из текущего состояния, и каждый прогон модели дает детерминистский прогноз «да/нет» для дождя в конкретном месте на конкретное время. Поэтому для получения вероятностного прогнозамодель нужно прогнать много раз при слегка различных начальных условиях, что создаст в итоге список различных «возможных вариантов будущего», где в некоторых вариантах пойдет дождь, а в некоторых – нет. Синоптики запускают ансамбль, скажем, из 50 моделей, и если дождь будет в 5 из них, то они говорят о вероятности осадков в 10 %.

Но как проверить, насколько хороши такие вероятности? Мы не можем создать простую матрицу ошибок, как в случае дерева классификации, потому что алгоритм никогда не утверждает категорически, пойдет дождь или нет. Мы можем начертить ROC-кривые, но они только показывают, получают ли дни с дождем более частые прогнозы, чем дни без дождя. Ключевая идея – необходимость в проверке- калибровке, то есть если мы возьмем все дни, когда синоптики говорили о вероятности дождя в 70 %, то дождь действительно должен идти примерно в 70 % таких дней. Синоптики относятся к этому очень серьезно – вероятности должны соответствовать фактам.

Читать дальшеИнтервал:

Закладка: