Борислав Козловский - Максимальный репост. Как соцсети заставляют нас верить фейковым новостям

- Название:Максимальный репост. Как соцсети заставляют нас верить фейковым новостям

- Автор:

- Жанр:

- Издательство:Литагент Альпина

- Год:2018

- Город:Москва

- ISBN:978-5-9614-7108-3

- Рейтинг:

- Избранное:Добавить в избранное

-

Отзывы:

-

Ваша оценка:

Борислав Козловский - Максимальный репост. Как соцсети заставляют нас верить фейковым новостям краткое содержание

Максимальный репост. Как соцсети заставляют нас верить фейковым новостям - читать онлайн бесплатно ознакомительный отрывок

Интервал:

Закладка:

Представьте себе тест вроде тех, которые печатали когда-то рядом с кроссвордами в газетах, где за каждый односложный ответ начисляют баллы. С пассажирами «Титаника» алгоритм – линейная модель – проделывает это так. Купили билет второго класса? 10 баллов. Первого класса? 100 баллов. Взошли на борт в английском порту Саутгемптон? 50 баллов. Во французском Шербуре? 5 баллов. (Этот признак не самый бесполезный для прогноза, потому что косвенно указывает, на каком языке – английском или французском – пассажир разговаривал, и легко ли ему было объясниться во время эвакуации с командой, состоящей преимущественно из англичан.) В конце концов баллы складываются, и если сумма больше пороговой, модель отвечает: «Выживет».

Откуда алгоритм знает, какую характеристику оценить в 500 баллов, а какую – всего в 10? Он начинает раздавать баллы наобум и потом уточняет их раз за разом на каждом примере, для которого известен правильный ответ, – это и есть обучение. Так выясняется, какие признаки важные, какие нет. Например, класс каюты: в первом выжили 63 % пассажиров, в третьем – всего 24 %. Или пол пассажира «Титаника»: среди женщин из списка – 74 % выживших, среди мужчин – всего 19 %.

В случае с записями в Facebook, про которые алгоритму надо ответить «показывать / не показывать», есть еще один небесполезный источник информации – это слова, из которых составлена запись. Если модель знает, что вы любите читать про ракеты, Марс и Илона Маска, то за каждое из этих слов выдаст много баллов, и случайные знакомые, делами которых вы не интересовались последние пять лет, имеют шанс пробиться к вам во френд-ленту со своими рассуждениями про запуск автомобиля в космос.

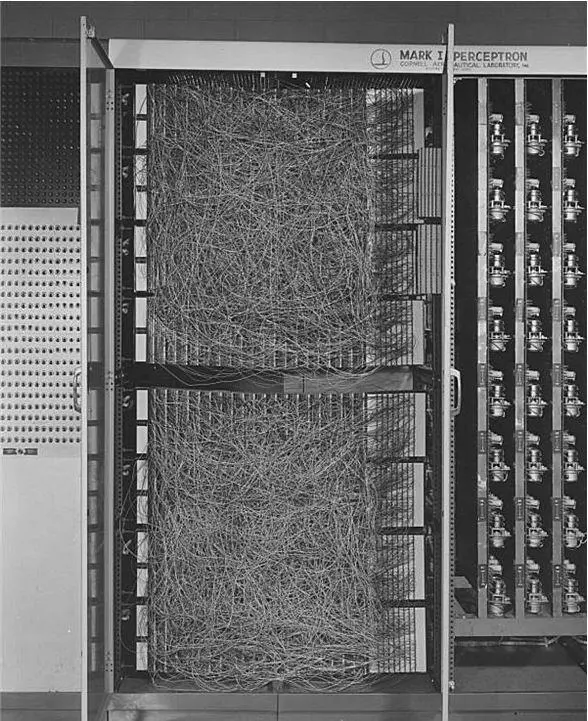

Рис. 8.Нейросети шестьдесят лет назад: американский математик Фрэнк Розенблатт придумал алгоритм под названием «персептрон» (его назвали бы однослойной нейросетью – или, что то же самое, линейной моделью) и построил способную обучаться вычислительную машину Mark I, не похожую на все остальные компьютеры. «Баллы» за каждый признак были реализованы в виде вращающихся стержней-резисторов, каждый из которых в процессе обучения подкручивал свой электромотор: чем сильнее стержень выкручен – тем больше баллов полагается за каждый признак

К чему простые и быстрые алгоритмы безнадежно глухи – так это к интонации и стилю. Они не отличают стихов от прозы. Скрытые цитаты и сарказм за пределами их понимания, потому что для простой модели ваша запись – мешок слов (у специалистов по машинному обучению это устоявшийся термин): слова либо есть, либо нет, а в каком порядке идут и что означают вместе, уже неважно. И если вы из чувства возмущения приводите кусок чужой прямой речи, который вас задел, и как угодно его комментируете – вас запросто заблокируют за оскорбительный контент.

Еще простые линейные модели не умеют видеть смысл в комбинациях признаков. Если на «Титанике» выжили все мужчины из второго класса, которые сели на лайнер в Саутгемптоне (потому что, скажем, всех их разместили в удачных каютах рядом со спасательной шлюпкой), то модель выдаст только скромную порцию баллов за Саутгемптон и за второй класс, а более тонких закономерностей не увидит – и ошибется в прогнозе.

Ситуация: врач скорой зашел в дом и, чтобы решить, надо ли везти пациента в больницу, начинает с вопроса «на что жалуемся?». С точки зрения математики это по-прежнему все та же задача про «Титаник»: есть люди, у них много характеристик (медики называют их словом «симптомы»), и в конце нужно ответить «да» или «нет».

Сценарии диалога врача с больным можно нарисовать в форме ветвящегося дерева: каждый следующий вопрос зависит от ответа на предыдущий. Если у пациента болит горло, надо спросить про температуру. Если хватается за сердце – проверить пульс.

Такие ветвящиеся деревья в мире алгоритмов – проверенный способ искать и находить то, что вам нужно, в огромных множествах. В 2007 году появилась интернет-игра «Акинатор», где ее главный персонаж – одноименный джин – предлагал угадать какого угодно персонажа (реального человека, героя мультфильма, историческую личность) за 15–20 вопросов, на которые можно ответить «да», «нет» или «не знаю». «Ваш персонаж существовал в реальности?» «Ваш персонаж женского пола?» «Ваш персонаж старше сорока лет?» «Ваш персонаж умер?» «У вашего персонажа больше одной головы?»

Каждый правильно заданный вопрос сужает поле вариантов – миллионы имен, упомянутых в кино и книгах, – примерно вдвое, следующий – еще вдвое, пока в итоге, на конце одной из ветвей дерева поиска, не остается один наиболее реальный кандидат. На десятом или двадцатом ходу (как повезет) Акинатор выдает ответ: царь обезьян Хануман, Емельян Пугачев, Человек-Паук. Хотя иногда и промахивается – вместо контрреволюционера и живого монгольского бога барона Унгерна предлагает революционера Григория Котовского.

Дерево решений в голове у врача точно так же позволяет проделать путь от общей ситуации к конкретной гипотезе. Подозрение на инфаркт: надо срочно вызывать скорую. Подозрение на ОРЗ: пусть пациент сидит дома и пьет чай под одеялом.

Все просто, когда правильные вопросы уже известны. Но сначала есть только десятки или сотни признаков в случайном порядке: пульс, давление, температура, диаметр зрачка, бледность кожи, громкость кашля, хрипы в груди или их отсутствие – и вопросы нужно научиться задавать в единственно верной последовательности.

Простой выход из положения: созвать консилиум из многих врачей, пусть даже мегаэрудированного доктора Хауса среди них и нет. Каждый врач знает все про три-четыре случайных симптома и делает все выводы только на их основе. Потом врачи голосуют, и консилиум записывает мнение большинства. Если, скажем, шесть из десяти говорят «везти в больницу» – больного везут в больницу. В машинном обучении это называют «ансамбль случайных деревьев».

Но можно опрашивать врачей и по очереди. Спросили первого про сотню пациентов. Второму предъявляем в основном пациентов, на которых ошибся первый, и уточняем его диагнозы. Третьему – тех, на которых ошибся второй. И так далее. Выглядит все так, как будто по поводу каждого нового больного эти врачи тоже голосуют, но их голоса весят по-разному. Примерно так работает «градиентный бустинг на деревьях» – кажется, самый мощный класс алгоритмов после нейросетей.

В чем его слабость? Он хорошо справляется с десятками и сотнями признаков, но дальше начинает буксовать. Тексты, в которых десятки тысяч разных слов, или картинки, где пикселей миллионы, – неподъемная для него информация. Вся она поддается обработке только в полупереваренном виде, когда текст или картинку кто-то уже превратил в ограниченный набор признаков: «доля красного на картине», «число жирафов на снимке», «длина текста в словах», «как часто в тексте встречаются местоимения». Но как раз со всем этим на порядок лучше обращаются нейронные сети. Они же – глубинное обучение, deep learning.

Читать дальшеИнтервал:

Закладка:

![Роберт Лихи - Не верь всему, что чувствуешь. Как тревога и депрессия заставляют нас поверить тому, чего нет [litres]](/books/1149058/robert-lihi-ne-ver-vsemu-chto-chuvstvuesh-kak-tre.webp)